Aby nadążyć za rozwojem technologii Internetu Rzeczy, potrzebne są zarówno ogromne zdolności obliczeniowe, jak i duża przestrzeń dyskowa na dane.

Internet Rzeczy (Internet of Things – IoT) to koncepcja zakładająca połączenie przedmiotów fizycznych ze światem cyfrowym. Stała się ona popularna dopiero w ostatnich latach, jednak sam termin powstał już w 1999 r.

Cyfrowy świat jutra

Obecnie branża informatyczna zmienia się w bardzo szybkim tempie. Kształtują ją potrzeby m.in. biznesu, nauki oraz osób prywatnych, a jednocześnie informatyka ma również wpływ i na nie same. Najlepiej widać to w przypadku urządzeń codziennego użytku, takich jak telefony komórkowe, komputery, smartwatche, systemy bezpieczeństwa w domu, sensory w samochodach itd. Nie są to urządzenia działające samodzielnie. Łączą się one dwukierunkowo zarówno między sobą, jak i z serwerami oraz dyskami, które znajdują się w jakimś odległym centrum danych.

Warto zwrócić uwagę na to, że 25 mld urządzeń zainstalowanych do 2020 r. będzie połączonych z IoT. Oznacza to, że potrzebna jest ogromna zdolność obliczeniowa, a także wielka przestrzeń dyskowa do obsługi coraz większej ilości danych pochodzących z tych urządzeń. Co więcej, będą one wykorzystywane w różny sposób i w różnym czasie w przeciwieństwie do tego, jak korzysta się z nich obecnie.

W jaki sposób IoT będzie wpływał na nasze życie dziś i w przyszłości? Media społecznościowe, dane w chmurze i urządzenia mobilne to wielka trójka, która oddziałuje na nasze życie. Nie ma nic nadzwyczajnego w tym, że robimy zdjęcie telefonem komórkowym, zapisujemy je w chmurze czy udostępniamy je na portalu społecznościowym. To typowy przykład ilustrujący sposób, w jaki jesteśmy połączeni ze światem cyfrowym. Warto również zwrócić uwagę, że za pomocą smartfona możemy zapłacić rachunki, deponować czeki, odtwarzać muzykę, skanować dokumenty, przeczytać recenzję interesującego nas filmu, zapłacić za parkowanie, zamówić obiad, sprawdzić, czy jakaś książka jest dostępna w bibliotece, wprowadzić i sprawdzić dane po ćwiczeniach fizycznych itd. Żadna z tych czynności nie jest niczym nietypowym. Płynie zatem z tego jasny wniosek: ludzie, jako społeczeństwo, w coraz większym stopniu polegają na dobrodziejstwie świata cyfrowego. Coraz bardziej zależy nam na tym, by czynności, które dotychczas wykonywaliśmy „analogowo”, odnalazły odzwierciedlenie w świecie cyfrowym. Konsekwencją tego będzie to, że coraz bardziej będziemy liczyli się z IoT.

Mimo znaczącego oddziaływania na trendy rozwojowe technologii serwerów, dysków i sprzętu sieciowego, IoT będzie miał również wpływ na zmiany w systemach chłodzenia centrów danych i nowe technologie systemów zasilania, a w szczególności na skalowalność tych systemów, ich pojemność i dostępność. W celu zapewnienia wystarczających zasobów energii i odpowiedniego chłodzenia sprzętu koniecznego do efektywnej obsługi IoT, również obsługa budynków, w których znajdują się centra danych, musi starać się nadążyć za ciągle rozwijającym się światem cyfrowym. Innego wyjścia po prostu nie ma. Zgodnie z raportem National Research Council kolejna generacja platform komputerowych będzie miała większą tolerancję na redundancję i awarie, podczas gdy tempo zwiększania osiągów będzie spadało, a Prawo Moore’a nie znajdzie już zastosowania w kolejnym dziesięcioleciu. Jeśli wszystko przebiegnie pomyślnie, a także dokona się ścisła integracja w dziedzinie informatyki, centra danych z jednej strony zanotują zmniejszone zużycie energii (nie tylko ze względu na wzrost efektywności), ale jednocześnie będą zapewniały większe zdolności obliczeniowe. Systemy dostarczania energii i systemy chłodzenia znajdują się na końcu tego łańcucha, zaś systemy informatyczne na jego początku. Każde zmniejszenie zużycia energii przez serwery, dyski czy sprzęt sieciowy spowoduje wzrost efektywności energetycznej systemów dostarczania energii i systemów chłodzenia. Taki jest właśnie główny przekaz: Internet Rzeczy doprowadzi do zwiększenia dostępu społeczeństwa do usług cyfrowych, a jednocześnie obniży zapotrzebowanie na energię, w porównaniu z obecnymi standardami i realiami technologicznymi.

Skalowalność

Biorąc pod uwagę zmiany, jakie się dokonały w ciągu ostatniego dziesięciolecia w dziedzinie sprzętu komputerowego, centra danych muszą dostosować się do innego typu działalności, polegającego na tym, że obciążenie nie będzie jednostajne. Jednocześnie muszą one zagwarantować niezawodność i efektywność energetyczną.

W elektronice (włączając w nią sprzęt komputerowy, komunikację między różnymi urządzeniami i oprogramowanie komputerowe), skalowalność definiuje się jako zdolność systemu, sieci czy procesu do radzenia sobie ze wzrostem obciążenia roboczego albo zdolność do rozszerzania się w taki sposób, by pomieścić większą ilość danych. Termin skalowalność może być jednak wykorzystywany na wielu różnych płaszczyznach. Znajduje bowiem zastosowanie w różnych branżach przemysłu, ale także samo jego znaczenie może być różne dla poszczególnych jego sektorów. Co więcej, można mówić o skalowalności „w górę” oraz o skalowalności „na zewnątrz”. W przedsiębiorstwie, które w dużej mierze polega na wydajności obliczeniowej, zapotrzebowanie na tę wydajność szybko prześcignie możliwości komputerów, a co za tym idzie – narazi firmę na straty. W tym przypadku skalowanie systemów informatycznych jest nieuniknione.

Warto się zastanowić, jak wygląda skalowanie w kontekście rozwoju Internetu Rzeczy. Skalowanie „na zewnątrz” oznacza w pewnym uproszczeniu dodawanie kolejnych jednostek (komputerów, dysków itp.) do już istniejącego systemu. Z kolei skalowanie „w górę”, również w pewnym uproszczeniu, oznacza rozbudowę poszczególnych jednostek przez np. dołożenie pamięci czy zastosowanie szybszego procesora. Obydwie koncepcje przyniosą różne konsekwencje dla systemów dostarczania energii i systemów chłodzenia. Skalowanie „na zewnątrz” doprowadzi do wzrostu zapotrzebowania na energię i chłodzenie (zajęcie większej przestrzeni przy niższym zagęszczeniu energetycznym komputerów), podczas gdy skalowanie „do góry” spowoduje zintensyfikowanie tego zapotrzebowania (zajęcie mniejszej przestrzeni przy większym zagęszczeniu energetycznym komputerów).

Wydajność

Komputery, które zostały specjalnie zaprojektowane do pracy w ramach ekosystemu Internetu Reczy, muszą przystosować się do nowych wymagań pod względem procesu obliczeniowego, łączności i przestrzeni dyskowej. Mogą one także wyglądać zupełnie inaczej niż tradycyjne serwery stelażowe. Znajdujące się w nich węzły są bardzo zagęszczone, a to oznacza, że zagęszczenie elektryczne jest również wysokie (W/m2). Ten współczynnik wymaga odpowiedzialnego zarządzania ciepłem w serwerowniach w celu zapewnienia optymalnej temperatury wewnątrz serwerów. Często należy zastosować chłodzenie cieczą, które zapobiega przegrzewaniu się procesora przy dużych obciążeniach roboczych. Dla przykładu, pewien znaczący producent sprzętu komputerowego ostatnio wprowadził na rynek nowy rodzaj serwera: każda obudowa w wysokości 4.3U (standardowa konfiguracja stelażu serwera, każdy stelaż albo jednostka 1U o wielkości = 19 cali szerokości i 1,75 cali wysokości, które stanowią minimalny rozmiar danego urządzenia) zdolna jest pomieścić 180 wkładów serwerowych. Wszystkie one pracują na jednym zasilaniu i chłodzeniu, a także na jednym układzie łączności.

Istnieje możliwość odłączenia wkładu serwera (hot swap/plugging) bez konieczności wyłączania zasilania albo odłączania kabli sieciowych. Już samo to powoduje, że system jest stabilniejszy i łatwiejszy w użytkowaniu. Ponieważ każdy wkład może funkcjonować na różnym oprogramowaniu, różne aplikacje mogą działać na różnych serwerach, a to z kolei pokazuje, jak wiele zastosowań ma takie urządzenie.

Zważywszy na to, że 10 obudów można ulokować w standardowej szafie serwerowej, łatwo policzyć, że w takiej szafie zmieści się 1800 serwerów, które pobierać będą łącznie 80 kW mocy z układu zasilania. Takie rozwiązania są przede wszystkim przewidziane dla wielkich przedsiębiorstw (np. zajmujących się hostingiem, analityką, grami, telekomunikacją itd.) i mogą pomóc w zmniejszeniu liczby standardowych serwerów o wysokości 1U, 2U czy też kasetowych.

Nie można zapominać o podstawowych prawach fizyki i termodynamiki: centra danych wciąż muszą zapewniać zasilanie oraz chłodzenie urządzeniom, które się w nich znajdują. W wielu z nich pewne wymagania dotyczące bezpieczeństwa, budowy czy działalności wciąż muszą być spełnione. Należy przeznaczyć odpowiednią ilość przestrzeni na sprzęt, przewidzieć, jak się będzie sytuacja rozwijała w przyszłości, zapewnić dostęp do zasilania i chłodzenia, umożliwić ustawienie temperatury powietrza i wody odpowiedniej dla sprzętu komputerowego, a także należy ciągle optymalizować koszty związane z działalnością i zużyciem energii.

Dostępne miejsce

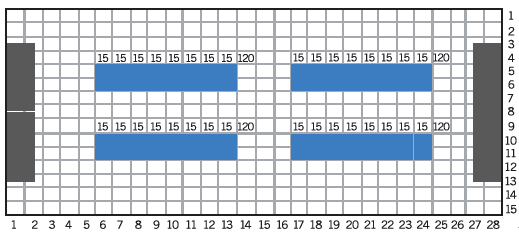

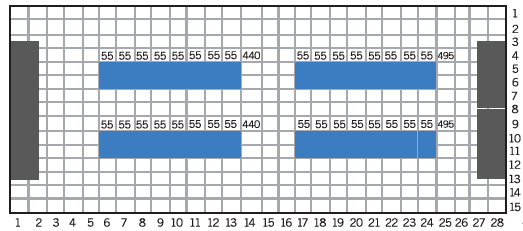

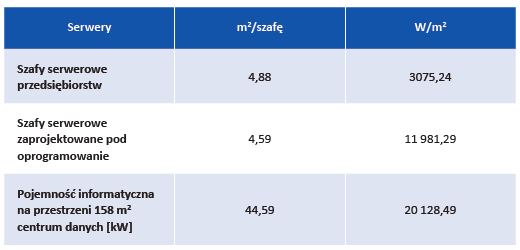

Wiele czynników napędza wzrost rozmiarów i pojemności centrów danych. Jednakże, jeśli wziąć pod uwagę to, w jaki sposób Internet Reczy wpływa na ich wielkość, rodzi się kilka pomysłów. Dzięki zastosowaniu serwerów o wysokim zagęszczeniu i zdefiniowanych programowo, możliwe staje się zmniejszenie powierzchni potrzebnej do ich ustawienia. Jeśli porównamy tradycyjne szafy serwerowe (10 szaf z 800 serwerami) z serwerami zdefiniowanymi programowo (6 szaf z 6400 serwerami), okaże się, że te drugie umożliwiają zmniejszenie przestrzeni przeznaczonej na serwery nawet o połowę. Należy pamiętać, że nie mówimy tutaj tylko o fizycznym miejscu, ale także o zmniejszeniu zapotrzebowania na całą infrastrukturę energetyczną i chłodzącą. Spójrzmy na to pod innym kątem – ten system serwerów jest w stanie dostarczyć czterokrotnie większą moc obliczeniową od tradycyjnych, szafowych systemów serwerowych (rys. 1 i 2, tabela 1).

Zasilanie sprzętu informatycznego i chłodzenia

W sytuacji, kiedy mamy do czynienia z ograniczonym dostępem do zasilania, tak jak w przypadku dostępu do sieci zasilającej albo kiedy instalowany jest nowy sprzęt komputerowy w już istniejącym centrum danych, wydajność sprzętu komputerowego na każdy wat mocy staje się istotnym czynnikiem podczas maksymalizowania mocy obliczeniowej.

Doskonały przykład takiej sytuacji pochodzi z sektora superkomputerów. W zależności od zapotrzebowania będą one instalowane w różnych częściach świata, będą także miały setki różnych konfiguracji sprzętowych, zasilania i chłodzenia. W tym sektorze panuje obecnie tendencja polegająca na tworzeniu superkomputerów, które zapewnią największą możliwą moc obliczeniową, a jednocześnie będą zużywać jak najmniej energii.

Temperatury właściwe dla sprzętu komputerowego

Zmniejszenie miejsca potrzebnego na instalację serwerów w centrum danych oraz zoptymalizowanie wydajności obliczeniowej zdadzą się na nic, jeśli sprzęt komputerowy nie będzie działał poprawnie z powodu pojawienia się temperatur wykraczających poza dopuszczalne wartości pracy. Rozwiązaniem tego problemu jest zastosowanie w superkomputerach i systemach zdefiniowanych programowo wewnętrznego chłodzenia cieczą. I choć chłodzenie cieczą jest stosowane już od dziesięcioleci, to statyczne i monolityczne komputery typu mainframe wykorzystywane były tylko do określonych celów. Współczesne komputery chłodzone wodą są zbliżone do serwerów szafowych, które umożliwiają „hot swap” bez straty zasilania czy chłodzenia w pozostałych jednostkach. Taka architektura w zdecydowany sposób zwiększa zdolności chłodzenia, gdyż płyn dostarczany jest bezpośrednio do procesorów, modułów pamięci i kart graficznych.

W zależności od typu komputera, należy także pamiętać o zastosowaniu chłodzenia powietrzem, gdyż pewna część ciepła generowanego przez procesory i wspomagające je obwody będzie wciąż wydzielana do powietrza w centrum danych. Dla przykładu, w przypadku dużych systemów moc wydzielana do powietrza w postaci ciepła może przekroczyć nawet 10 kW, co stanowi równowartość mocy dla szafy serwerowej o umiarkowanym zagęszczeniu, chłodzonej powietrzem.

Zmniejszenie kosztów energii

Gdyby usługi w tzw. chmurze były państwem i jeśli wziąć pod uwagę zużywaną przez nie energię, znalazłyby się one na 5. miejscu w światowym rankingu zużycia energii. Patrząc na to z perspektywy inżynierii energetycznej, obniżenie zużycia i kosztu energii jest najlepszym rozwiązaniem wprowadzonym przez IoT. Jeśli centrum danych będzie znajdowało się w mniejszym budynku, to mniejsze będzie zapotrzebowanie na energię i chłodzenie.

Największych oszczędności należy jednak szukać w sprzęcie chłodzonym wodą. Dzięki zastosowaniu tej technologii właściwie eliminuje się zużycie energii przez wentylatory i centralę wentylacyjną. Woda, która chłodzi wewnętrzne komponenty komputerów, może osiągnąć temperaturę od 27°C do 38°C. Dzięki temu okazuje się, że na całym świecie można chłodzić komputery przy wykorzystaniu systemów total free cooling albo free cooling, przy jednoczesnym zastosowaniu minimum chłodzenia mechanicznego. Dlatego centra danych, które obsługują IoT, mogą zmniejszyć zużycie energii w stosunku do tradycyjnych centrów danych.

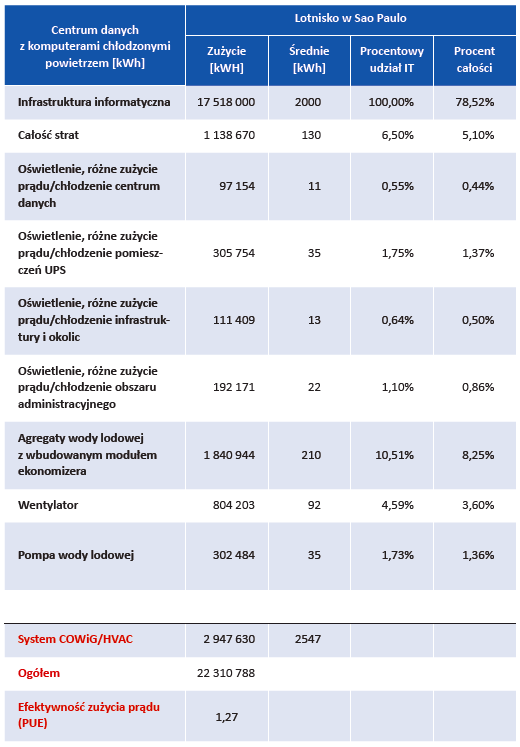

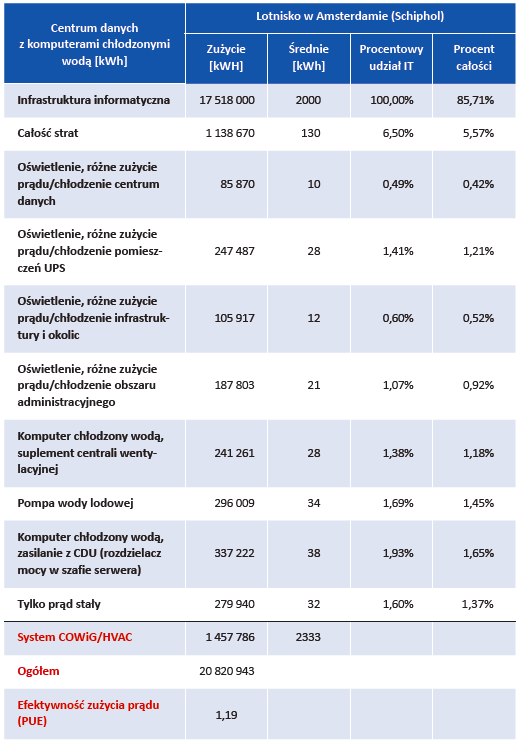

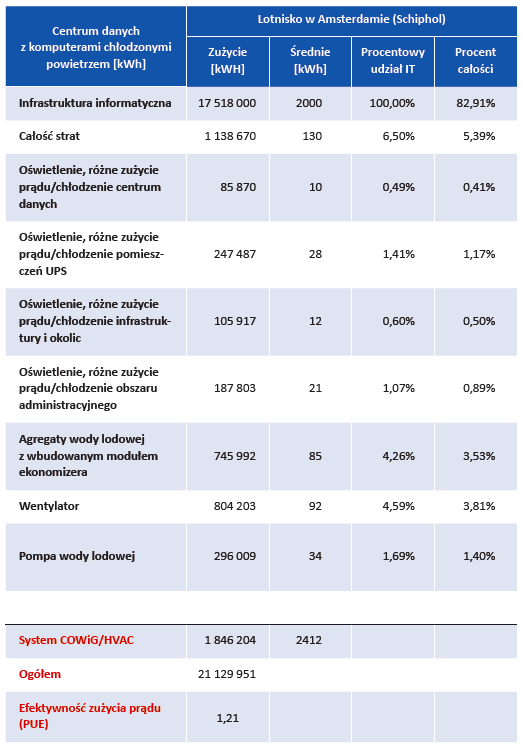

W celu ilustracji tych zjawisk przedstawiono analizę zużycia energii w dwóch różnych centrach danych, w różnych miejscach na świecie (Sao Paulo i Amsterdam). Jedno z nich korzysta z systemu chłodzenia powietrzem, drugie zaś wykorzystuje superkomputery i chłodzenie wodą. Dane przedstawione w tabelach 2 i 3 pozwalają zrozumieć, dlaczego zastosowano dwa różne typy serwerów, które mają wpływ na zużycie energii i wykorzystanie systemu chłodzenia. W tych centrach wdrożono odpowiednio podstawowy system chłodzenia oraz agregaty wody lodowej i centralę wentylacyjną.

Wnioski płynące z tej analizy to:

-> strategia oszczędności energetycznej w systemach superkomputerów pod względem organizacji chłodzenia umożliwia wykorzystanie bardzo ciepłej wody do utrzymania całego systemu w odpowiedniej temperaturze;

-> chłodzenie wodą w porównaniu z chłodzeniem serwerów powietrzem sprawdza się w bardzo ciepłych klimatach, np. Sao Paulo;

-> różnice w zużyciu energii na chłodzenie w Sao Paulo są znaczące: system chłodzony wodą zużywa ponad 50% mniej energii niż system chłodzony powietrzem (tabela 2);

-> w bardziej umiarkowanym klimacie, jak w Amsterdamie, zużycie energii do chłodzenia całego systemu wodą jest o 37% mniejsze niż w systemach serwerów chłodzonych powietrzem (tabela 3);

-> różnica wynika z tego, że w umiarkowanym klimacie systemy chłodzenia wodą mogą lepiej i efektywniej wykorzystywać dostępne zasoby, niż te same systemy w ciepłym klimacie;

-> wykorzystanie chłodzenia wodą zdecydowanie zmniejsza zużycie energii przez wentylatory w centrum danych, a niekiedy sprowadza je do zera, w zależności od taktyki zarządzania ciepłem serwera. Z całą pewnością wentylatory wciąż znajdują zastosowanie w innych częściach centrum danych, takich jak pomieszczenia UPS;

-> w zależności od lokalizacji i od założonego działania systemu superkomputera, chłodzenie mechaniczne można w pełni wyeliminować. Centralną wentylację, np. pompy i agregaty wody lodowej, można zastąpić mniejszymi, „wzmocnionymi” agregatami wody lodowej, które zostały zaprojektowane, by wprowadzać wodę do obiegu chłodzenia, kiedy zachodzi taka potrzeba. W pozostałych przypadkach tę samą rolę spełnia sprzęt służący do odprowadzania ciepła, np. wieże chłodnicze czy chłodzenie w obiegu zamkniętym.

Automatyczna alokacja zasobów

W ramach szerszej strategii pod hasłem „zakład jako usługa”, systemy dostarczania energii i systemy chłodzenia będą działały w większym stopniu na bazie automatyzacji oprogramowania, która jest ściśle powiązana z rzeczywistym obciążeniem roboczym komputerów. Wykorzystanie takiego podejścia w superkomputerach może się przyczynić do zmniejszenia zużycia energii potrzebnej do wykonywania ogromnych ilości obliczeń. Może to również pozytywnie wpłynąć na niezawodność węzła i zmniejszyć ilość danych przesyłanych między komputerami a routerami przez dystrybuowanie tych danych do różnych kaset.

Przyjmując takie założenie, teoretycznie można powiedzieć, że zwiększy się efektywność energetyczna, gdyż węzły, na których znajdują się duplikaty danych, mogą albo przejść w stan niskiego poboru mocy, albo zupełnie się wyłączyć, w zależności od tego, jak zaprogramowany zostanie system. Zwiększa to również niezawodność usługi, ponieważ jeśli któryś serwer albo któraś szafa przestanie działać w wyniku błędu, zadanie zostanie przeniesione do innego węzła, w którym znajdują się duplikaty danych, co spowoduje, że praca nie zostanie przerwana nawet na chwilę. Wymaga to jednak elastycznego systemu dostarczania energii oraz systemu chłodzenia, które będą odpowiednio reagowały na zmiany w dostępie do danych (zarówno w jednym, jak i w kilku centrach danych).

To wszystko jest wynikiem tego, że od firm i przedsiębiorstw coraz częściej oczekuje się: większego wykorzystywania aplikacji mobilnych, ciągłego przechowywania i umożliwiania dostępu do istotnych dokumentów, takich jak dokumentacja medyczna, dane organizacyjne czy magazynowe, a także uelastyczniania procesów obciążenia roboczego systemów przetwarzania danych Big Data, by zagwarantować wykonywanie skomplikowanych i spójnych analiz danych.

Co dalej?

Internet Reczy, napędzany przez systemy komunikacji i zmiany w infrastrukturze zakładów przemysłowych oraz budynków komercyjnych, użyteczności publicznej i prywatnych, będzie się rozwijał i oferował coraz bardziej zaawansowane funkcje, a przyczynią się do tego liderzy branży, analitycy, dyrektorzy korporacyjni odpowiedzialni za ustanawianie kierunku, w którym zmierzają ich organizacje, warte wiele miliardów dolarów. Przykładowo, przeprowadzono już wiele badań dotyczących samochodów bez kierowcy, które „nie mogą spowodować wypadku”. Powodzenie funkcjonowania i wdrożenia tego typu pojazdów zależy głównie od mocy obliczeniowej i zdolności do przetwarzania danych przez centra danych, które łączą się z nimi przez Internet. Innym przykładem, choć na zdecydowanie mniejszą skalę, jest samodzielne monitorowanie stanu zdrowia przez pacjentów. Mikroelektromechaniczne systemy, czujniki i niskonapięciowe odbiorniki radiowe, które przewyższają swoimi możliwościami wszystkie dostępne obecnie na rynku smart bandy (inteligentne opaski), zostały zamontowane w wielu różnych urządzeniach i generują ogromne ilości danych na temat schematów aktywności danej osoby, co umożliwia analizę i zmianę przyzwyczajeń w celu poprawy stanu zdrowia. Mimo że dane podstawowe są zbierane lokalnie, to cała analiza i przechowywanie odbywa się w centrum danych, połączonym z tym urządzeniem przez Internet. Na podstawie tych przykładów (i wielu innych najnowszych technologii opracowywanych przez prywatne firmy, agencje rządowe czy uniwersytety) można stwierdzić, że rozwój technologii i funkcji Internetu Reczy będzie wpływał na zwiększanie niezawodności i efektywności systemów informatycznych, a także samych centrów danych.

Opracowywana jest obecnie jeszcze inna technologia: biorąc pod uwagę, ile informacji dziś otrzymujemy z Internetu, technologia „poznania wspomaganego” (augmented cognition) pomoże nam posortować wszystkie dane cyfrowe i wybrać te naprawdę istotne. Jak na ironię, technologia, która pozwoli uporządkować bezład cyfrowy, pochodzi z tego samego źródła, w którym on powstał. Tak właśnie wygląda przyszłość.

Autor: Bill Kosik jest technologiem w HP Data Center Facilities Consulting (DCFC). Odpowiada za realizację prac projektowych, przeprowadzanie szkoleń, mentoring inżynierów wewnętrznych i zespołów konsultacyjnych, a także za badanie i analizę zagadnień związanych ze zużyciem energii w centrach danych.

Tekst pochodzi ze specjalnego wydania “Fabryka 4.0“. Jeśli Cię zainteresował, ZAREJESTRUJ SIĘ w naszym serwisie, a uzyskasz dostęp do darmowej prenumeraty w formie drukowanej i/lub elektronicznej.