Przedsiębiorstwa stale poszukujące nowych sposobów poprawy dostępności zakładowych sieci przemysłowych nie mogą być zawiedzione ofertą nowych, innowacyjnych urządzeń monitorujących i narzędzi diagnostycznych. W rzeczywistości rynkowej segment prewencyjnej diagnostyki sieci wykazuje tendencję rozwojową, a co za tym idzie, firmy będą miały szansę znacząco obniżyć całkowite koszty produkcji, skrócić czas przestojów oraz podnieść swoją efektywność.

Awaria sieci zakładowej zazwyczaj negatywnie odbija się na wynikach produkcji. W postępowych organizacjach od lat stosowano najnowocześniejsze rozwiązania w dziedzinie diagnostyki prewencyjnej maszyn i urządzeń, wobec czego oczywiste są dążenia do objęcia programem diagnostycznym także sieci przemysłowych.

Awaria sieci zakładowej zazwyczaj negatywnie odbija się na wynikach produkcji. W postępowych organizacjach od lat stosowano najnowocześniejsze rozwiązania w dziedzinie diagnostyki prewencyjnej maszyn i urządzeń, wobec czego oczywiste są dążenia do objęcia programem diagnostycznym także sieci przemysłowych.

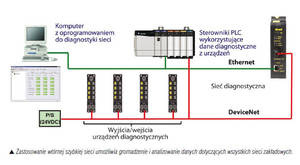

Diagnostyka prewencyjna pozwala uzyskać obraz sieci, w której może wystąpić usterka. Zastosowanie wtórnej szybkiej sieci zakładowej (zwykle typu Ethernet) do monitorowania danych z sieci podstawowej umożliwia gromadzenie i analizowanie danych dotyczących wszystkich zakładowych sieci informatycznych. Technika ta umożliwia znaczące ograniczenie nieplanowanych przestojów sieci – a nawet ich uniknięcie – poprzez skorygowanie usterek w sieciach, zanim nastąpi ich zawieszenie z powodu błędu.

Znaczenie sieci dla pracy zakładu

Dlaczego monitorowanie sieci zakładowej jest szczególnie ważne? W przeciwieństwie do środowiska biurowego, gdzie do pewnego stopnia toleruje się krótkie przerwy w działaniu systemów komunikacyjnych, zakładowy system wymiany informacji to kręgosłup produkcji. Przemysłowe systemy komunikacji w wielu branżach odpowiadają za dostarczanie danych o najwyższym znaczeniu dla spełnienia wymogów prawnych. Przerwę w funkcjonowaniu takiej sieci boleśnie odczuwa się w postaci słabszych wyników finansowych wynikających z utraconej produkcji.

W uproszczeniu narzędzia do diagnostyki sieci można podzielić na trzy grupy:

• narzędzia do diagnostyki i konfiguracji sieci,

• analizatory protokołów sieciowych,

• analizatory sygnałów fizycznej warstwy sieci.

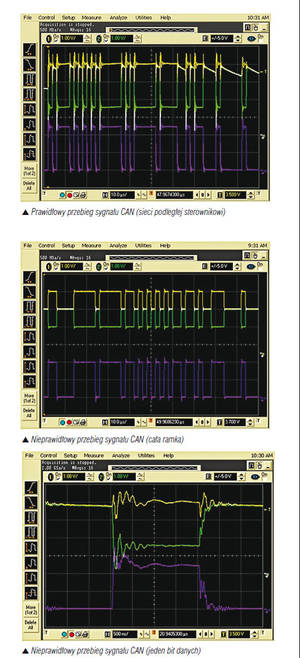

Pierwsze dwie grupy narzędzi są przydatne w diagnozowaniu problemów po wystąpieniu usterki w sieci, a także w pewnym stopniu mogą ostrzegać o nieuchronnie nadciągającej awarii. Z kolei narzędzia z ostatniej grupy są dużo bardziej pomocne w zrozumieniu problemów dotyczących fizycznej warstwy sieci, mogących skutkować jej awarią. Przykładowe zrzuty ekranów ilustrują wykryte zakłócenia sygnału CAN (Controller Area Network – sieć podległa sterownikowi), wynikające z typowego uszkodzenia medium w sieci DeviceNet.

Pierwsze dwie grupy narzędzi są przydatne w diagnozowaniu problemów po wystąpieniu usterki w sieci, a także w pewnym stopniu mogą ostrzegać o nieuchronnie nadciągającej awarii. Z kolei narzędzia z ostatniej grupy są dużo bardziej pomocne w zrozumieniu problemów dotyczących fizycznej warstwy sieci, mogących skutkować jej awarią. Przykładowe zrzuty ekranów ilustrują wykryte zakłócenia sygnału CAN (Controller Area Network – sieć podległa sterownikowi), wynikające z typowego uszkodzenia medium w sieci DeviceNet.

Do wykrywania problemów w fizycznej warstwie sieci konieczne jest porównywanie bieżących odczytów parametrów sieci ze znanymi, prawidłowymi wartościami. Najlepszą metodą jest pobranie „wzorcowych” odczytów w chwili, gdy sieć jest oddawana do eksploatacji (w stanie idealnym) albo porównywanie bieżących odczytów z zaleceniami dotyczącymi danej sieci (tzn. zalecanymi przez organizację ODVA zakresami tolerancji dla sieci DeviceNet). Ciągłe porównywanie odczytów z wartościami wzorcowymi lub standardowymi umożliwia czynną odpowiedź na wykroczenie parametrów sieci poza dopuszczalne zakresy i to często przed całkowitym zawieszeniem sieci.

Dzięki zastosowaniu sieci Ethernet do stałego monitorowania danych w sieci podstawowej uzyskane informacje mogą być dostarczane do zwykłych systemów monitorujących, opartych na sterownikach PLC/PAC lub komputerach PC. Dostępne narzędzia dla komputerów PC umożliwiają łatwe wyświetlanie uzyskanych danych oraz sugerują przyczyny niedopuszczalnych wartości parametrów. Dane te mogą być także przechowywane w oprogramowaniu typu „historian” do celów przyszłej analizy.

Podsumowując, najnowocześniejsze narzędzia do diagnostyki sieci pozwalają połączyć się z posiadaną siecią przemysłową i stale monitorować jej pracę, co ma niebagatelny wpływ na zapewnienie najwyższej wydajności zakładu przemysłowego.

Michael Frayne jest kierownikiem ds. produktu w dziale interfejsów sieciowych w firmie Molex z siedzibą w Waterloo (stan Ontario).

Artykuł pod redakcją Michała Andrzejczaka

*******

Zatykanie dziury w bezpieczeństwie zakładów przemysłowych

Uchwalony w następstwie wydarzeń 11 września 2001 r. program poprawy bezpieczeństwa wewnętrznego amerykańskiego rządu zapoczątkował bitwę na rynku dostawców automatyki procesowej. Program wymagał od wszystkich operatorów krytycznych lub potencjalnie niebezpiecznych procesów – jak m.in. zakłady wodociągowe, podstacje elektroenergetyczne oraz zakłady przemysłu naftowego, gazowniczego i chemicznego – udowodnienia, że są zabezpieczeni przed atakami z zewnątrz, szczególnie prowadzonymi za pośrednictwem Internetu.

Kontrole pozwoliły rządowi stwierdzić coś, o czym specjaliści z sektora przemysłowego wiedzieli od lat – oprogramowanie i stosy IP współczesnych systemów sterowania są skrajnie podatne na awarie. Czasem zaledwie krótkie przeciążenie sieci o 10–20% może zakłócić lub nawet zatrzymać cały proces. Obecnie operatorzy i organizacje, jak NAMUR i NERC, naciskają dostawców sterowników, aby w ich ofercie znajdowały się bezpieczne systemy sterowania.

Celem działań tych organizacji jest uzgodnienie powszechnie akceptowanej metody testów urządzeń przemysłowych oraz klasyfikacji podobnej do poziomów bezpieczeństwa SIL (Safety Integrity Level). Planowaną klasyfikację poziomów zapewnienia bezpieczeństwa SAL (Security Assurance Level) opracowuje się obecnie jako część 4. standardu ISA 99.

Od 5 lutego 2009 r. w przemyśle produkcji procesowej funkcjonuje nowy standard, wspierany przez kilku dużych graczy oraz amerykański rząd z Departamentem Bezpieczeństwa Wewnętrznego (DHS) na czele. Jego wdrożenie to dla wielu firm nie lada kłopot ze względu na „trudne” zalecenia, szczególnie w odniesieniu do starych systemów. Nie ma jednak wątpliwości, że wyznacza on przyszłe podejście do kwestii bezpieczeństwa, a wielcy producenci z branży systemów sterowania dołożą starań, aby ich systemy automatyki procesowej były z nim zgodne.

Pytanie tylko, czy certyfikaty SAL zostaną zaakceptowane przez pracowników zakładów, którzy odpowiadają za bezpieczeństwo, i czy ostatecznie mogłyby one funkcjonować łącznie z certyfikatami SIL, których muszą oni przestrzegać wdrażając sieci bezpieczeństwa? Przeszkodzić temu może dominacja komercyjnych standardów informatycznych. Jeżeli z tego powodu przedsiębiorstwa produkcji dyskretnej i procesowej będą w odmienny sposób traktować kwestie bezpieczeństwa, odbije się to czkawką użytkownikom i dostawcom, którzy będą musieli sobie radzić z dwoma zupełnie odmiennymi podejściami.

To w najbliższych latach kolejny front wojny między producentami oprogramowania a dostawcami automatyki. Za wcześnie jeszcze na typowanie zwycięzcy, ale pojedynek ten będzie z pewnością interesujący. Kilka najbliższych lat zadecyduje o kierunku rozwoju rozwiązań w zakresie bezpieczeństwa zakładowych systemów informatycznych.

Ed Nabrotzky jest kierownikiem ds. produktu na rynkach światowych w firmie Molex.

*******

Autor: Michael Frayne